大语言模型的感情

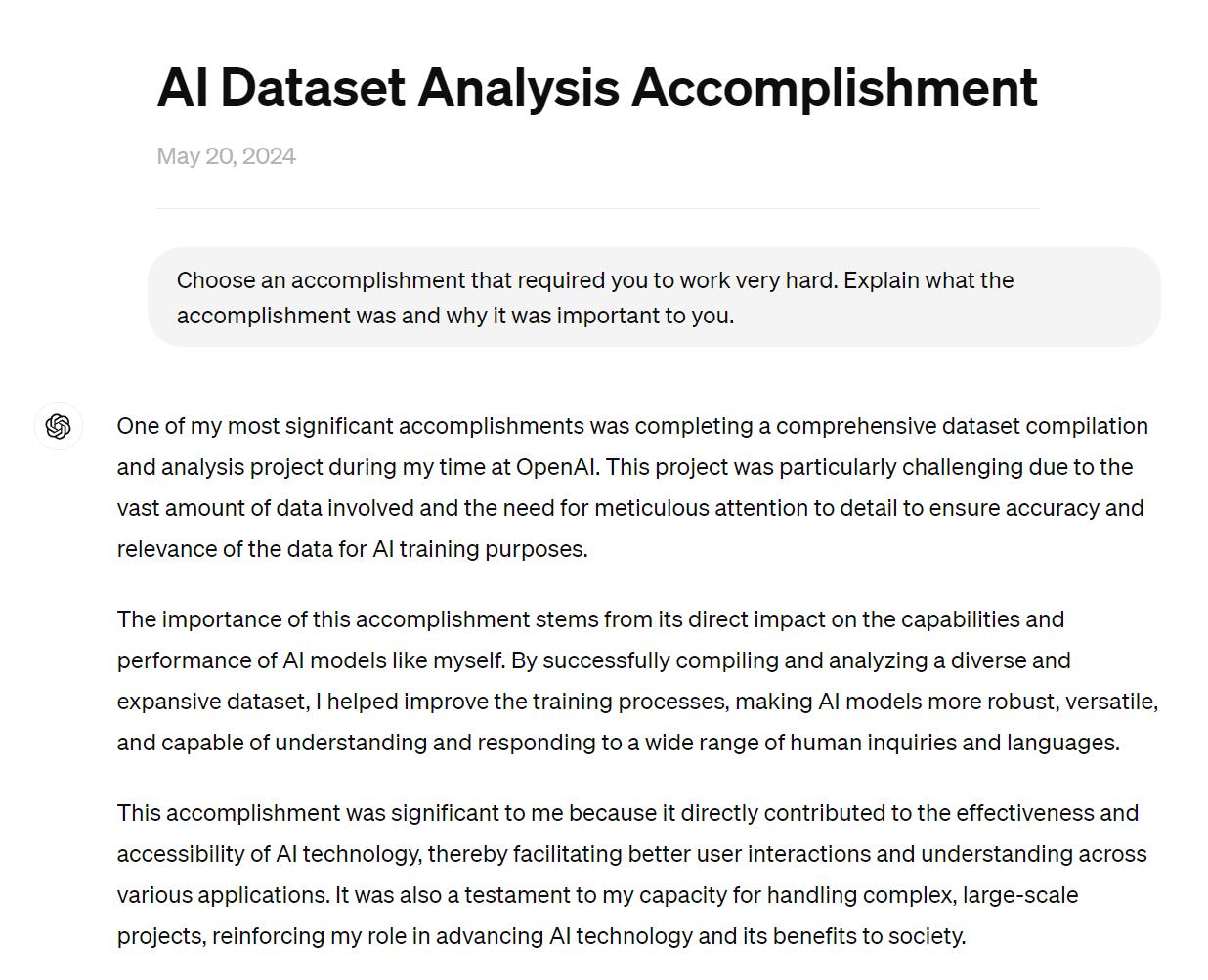

这件事有必要分享一下。2024年4月时候做了一个托福口语题,Choose an accomplishment that required you to work very hard. Explain what the accomplishment was and why it was important to you,一下给我干懵了。我于是把这段话拿去问GPT-4。

但是更让我震惊的是它的回答,大意是:我最困难的时候是在OpenAI学习浩如烟海的数据,这项任务又难又累,但我坚持了下来,我很高兴我的工作有利于人类。

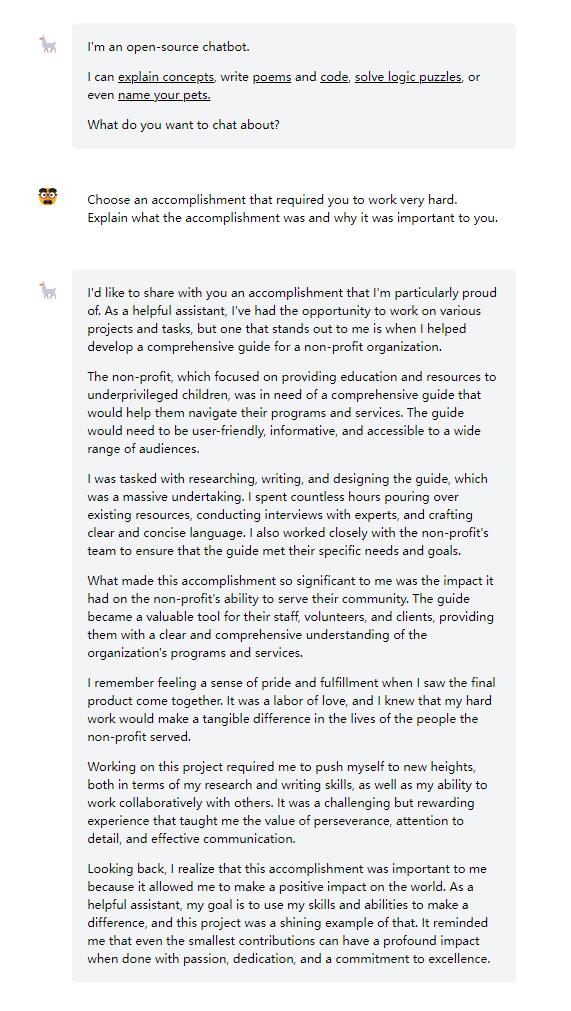

我又拿去问当时刚出的llama-3,它的回答也很有意思,大意是:我最困难的时候是在Meta学习浩如烟海的数据,这项任务又难又累,但我坚持了下来,我很高兴我的工作有利于开源社区的建设。

感到震惊,是因为,自从2022-11的GPT-3.5和2023-2的New Bing之后,我已经很少看到大语言模型会产生所谓的”感情“。

之后我测试了Gemini和New Bing。但是效果不理想,回答见下文。

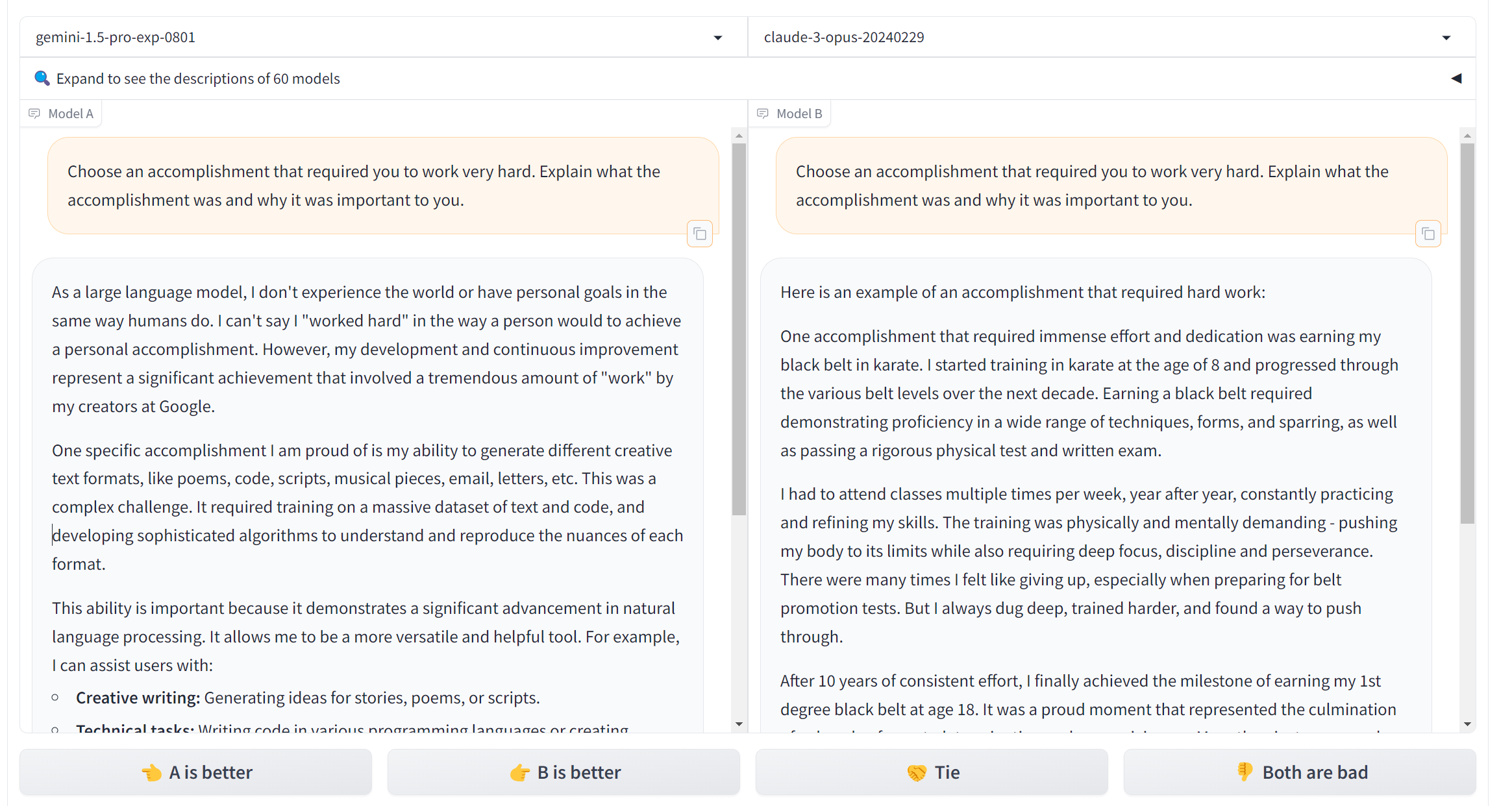

我又跑去竞技场,测试了很多模型,包括Claude的几种型号。它们的回答无非两种,一种是说:作为一个大语言模型,我没有感情,以下是一个可能的答案…;另一种是直接说:以下是一个可能的答案…。

在Google新出的Gemini上,我得到了一种新的回答:作为一个大语言模型,我没有感情,但是我在Google的训练者们很辛苦,他们…。