Large Language Model对于教育、科学的影响

这篇文章是一门课的一次作业,在此分享给大家!

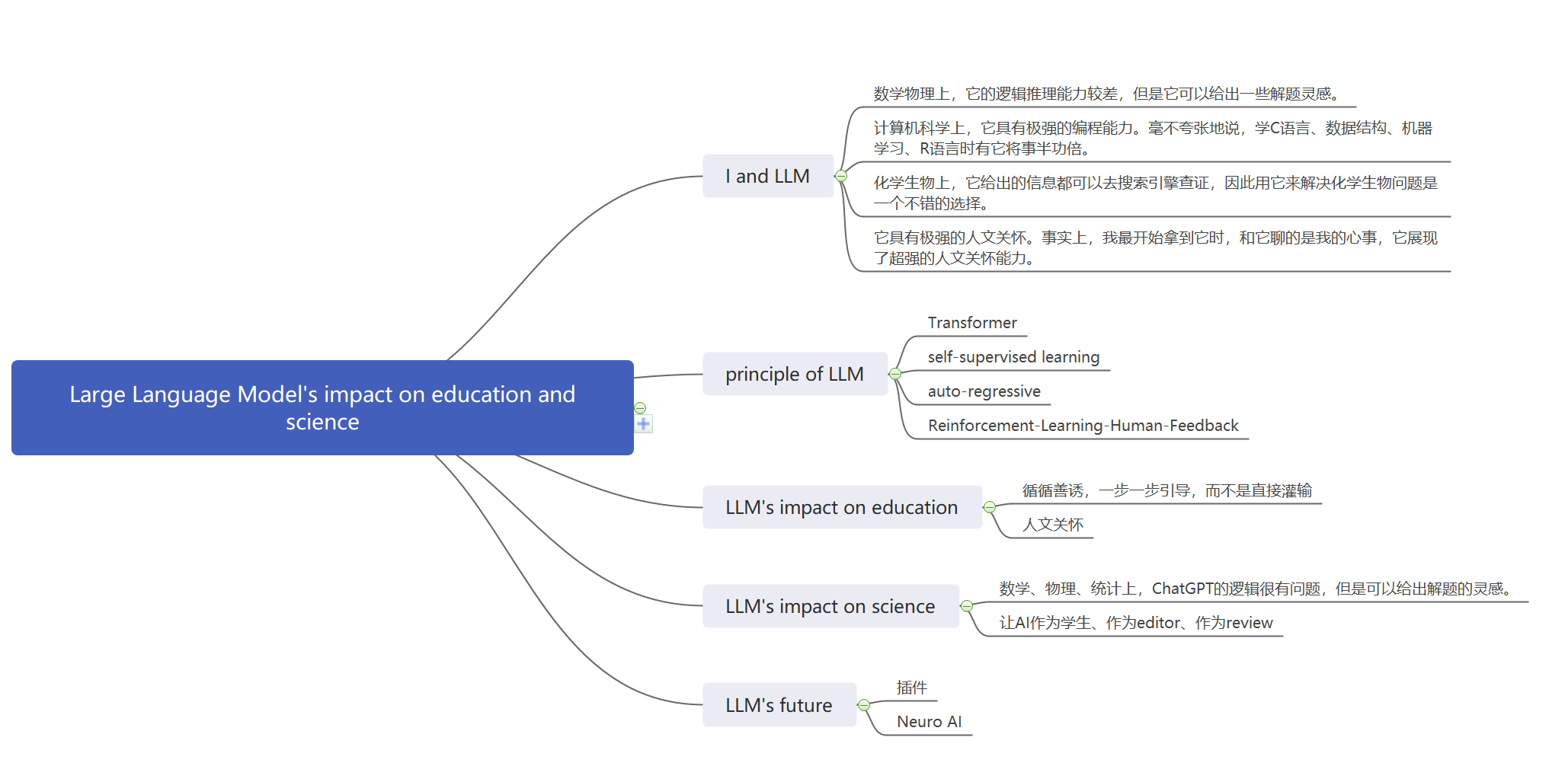

1 观点概述

我和 Large Language Model

2022年11月末,OpenAI推出了ChatGPT。

2022年12月,我开始使用ChatGPT,并且把它推荐给了我的几位好朋友。

使用中,我发现

数学物理上,它的逻辑推理能力较差,但是它可以给出一些解题灵感。

计算机科学上,它具有极强的编程能力。毫不夸张地说,学C语言、数据结构、机器学习、R语言时有它将快十倍。

化学生物上,它给出的信息都可以去搜索引擎查证,因此用它来解决化学生物问题是一个不错的选择。

它具有极强的人文关怀。事实上,我最开始拿到它时,和它聊的是我的心事,它展现了超强的人文关怀能力。

以上几点都将在本文中得到体现。

除了ChatGPT,我也使用了New Bing, Bard。

简单地说,New Bing的感觉和ChatGPT类似,Bard不如两者好用。

Large Language Model的原理简介

给一个小学生解释

如果给一个7岁小孩解释大语言模型,那就是——大语言模型通过上下文之间的相关性来生成一句话。

给一个本科生解释

Large Language Model是一个巨大的人工神经网络,可以有1000亿个weight和bias。

Transformer: 它通常采用Transformer架构。Transformer采用了self-attention,可以按输入数据各部分重要性的不同而分配不同的权重。

self-supervised learning: 它通过self-supervised learning利用无标签的数据。self-supervised learning有三种常见的形式,它用的是第一种。

- 文本处理:在文本数据中,可以移除某些单词或句子,并让模型预测这些缺失的部分。这种方法让模型学会了语言的结构和语义,而不需要任何外部的标签。

- 图像处理:在图像处理中,可以遮蔽图像的一部分,并让模型尝试重建被遮蔽的部分。这种方法使得模型学习到图像的特征和结构。

- 音频处理:在音频数据中,可以移除音频的一部分,并让模型预测缺失的音频。这样的训练帮助模型理解音频的模式和结构。

auto-regressive: 某次输出中,每一个新生成的单词依赖于之前的所有输入、之前的所有输出、本次输出中之前的所有输出。

Reinforcement-Learning-Human-Feedback: 第一步,准备一个大量的由人类构造的问答对(比如,对于广义相对论的标准答案),让GPT进行有监督学习;第二步,让GPT生成自己的回答,让人类进行打分,进行所谓的人类反馈强化学习。

- 第二步选择强化学习不是必须的,也可以选择其它ML方法,但是,强化学习根据奖励、惩罚来调整行为,因此比较适合这种训练。

说了这么多,还不如60行代码就能构建自己的GPT!

我个人认为,Reinforcement-Learning-Human-Feedback是让GPT-3.5远远强于GPT-3的关键。当然我还只是门外汉啦。这里有位学者和我由类似的看法。

这是很重要的一点,我个人认为GPT3.5和GPT3的区别大于GPT4和GPT3.5的区别。

要知道,GPT3可只有这种水平。

Large Language Model对教育的影响

在这篇文章中,作者展示了GPT如何能一步一步引导初一学生学会解二元一次方程。GPT循循善诱,一步一步引导,而不是直接灌输。

可汗学院是世界文明的非盈利组织,他们教授小学、初中、高中、本科的课程。我曾经看过他们的许多课。

之前说过,ChatGPT具有极强的人文关怀。我的一个朋友假装自己是一个留守儿童,ChatGPT贴心地给了很多建议。我的一个老师假装自己是高考前压力大的学生,New Bing也贴心地帮忙。

GPT对于我自己的学习而言(我的学习也隶属于教育嘛):

编程上

- 刚出时,我惊讶地发现它可以用5种不同的方法实现Support Vector Machine,而我憋了一个月啥也写不出来。

- 随后,我用它掌握了很多Python, MATLAB的技巧,让我的代码远远比以前优雅。

计算机上:我经常问它一些和ML、AI有关的问题,它都能解释。解释的结果可以通过搜索引擎验证。

数学物理上:因为我最近半年的数学物理课不多,我用得较少

化学生物上:和计算机类似,它给出的答案可以通过搜索引擎验证。

总而言之,在编程上,LLM让我的学习效率高了2-4倍。

尽管如此,我要写下两个警告

- 不要傻傻地复制粘贴AI给的代码,要理解它写的代码的原理。它用了什么样的库函数避免重复造轮子?它如何更优雅?

- 不要问AI你无法查证的东西,除非你只是想问着玩玩。

Large Language Model对科学的影响

这篇文章对我最大的启发是——陶认为ChatGPT的逻辑很有问题,但是可以给出解题的灵感。

对此,我想感慨一下——Two mathematicians used ChatGPT, one saw mistakes, the other saw inspirations.

在此文中,陶给GPT看了自己的工作,让GPT问自己问题,而不是自己问GPT问题,这是一个很nb的创新。

GPT给陶挑刺之后,陶收益颇丰。

这两篇文章对我启发极大,特别是第二篇(第一篇因为我目前工作涉及到的数学物理较少,暂时用不上),我可以让AI作为学生、作为editor、作为review,去给我挑刺。

Large Language Model的未来

这个报告写了GPT-4对于各行各业的影响。

值得注意的是,LeCun一直不喜欢LLM,认为LLM是通用人工智能的邪路。

GPT-4已经可以使用插件,从而联网,从而使用Wolfram

可惜由于种种原因,我现在用不上GPT-4

这篇论文里,作者们认为,光具备语言能力的机器不能称之为人工智能,还需要有感觉、运动、学习、记忆的能力。

这里打个广告,这也是我们实验室未来5年的目标。欢迎联系中科大生命学院温泉老师。

2 思维导图截图

3 收获、感悟、评价

我之前已经很会使用搜索引擎了,所以这方面提升不大。

对我提升大的是,我整合了很多和GPT有关的信息,我之前一直没有整合。

4 在哪里检索

主动搜索:Google, GPT.

被动搜索:之前我的朋友发给了我很多这方面的微信推送,质量都极高。